共计 2472 个字符,预计需要花费 7 分钟才能阅读完成。

最近我在浏览 GitHub 上的热门项目时,偶然发现了一个很有意思的讨论:NVIDIA 的 API Catalog (NIM) 居然悄悄更新了一波国产大模型,其中最引人注目的莫过于 GLM-4.7 和 Minimax-m2.1。

作为一个长期在 AI 各种 API 之间反复横跳的“接口调式员”,我对于这种“免费”且“高性能”的羊毛向来是没有任何抵抗力的。尤其是考虑到 NVIDIA 在硬件层面的统治力,由他们托管的模型,推理速度和稳定性肯定差不到哪去。

于是,我第一时间去申请了 Key,把手头的几个自动化脚本切过去试了试。今天就来聊聊这次的发现,以及这两个模型在 NVIDIA 平台上的实际表现。

为什么 NVIDIA 要做这件事?

大家对 NVIDIA 的印象可能还停留在“显卡狂魔”或者“股价冲天”上。但实际上,老黄这两年在软件生态上下的功夫一点也不比硬件少。NIM (NVIDIA Inference Microservices) 就是其中的核心一环。单来说,NVIDIA 想要证明:“我的卡不仅算力强,跑大模型更是快到飞起。”

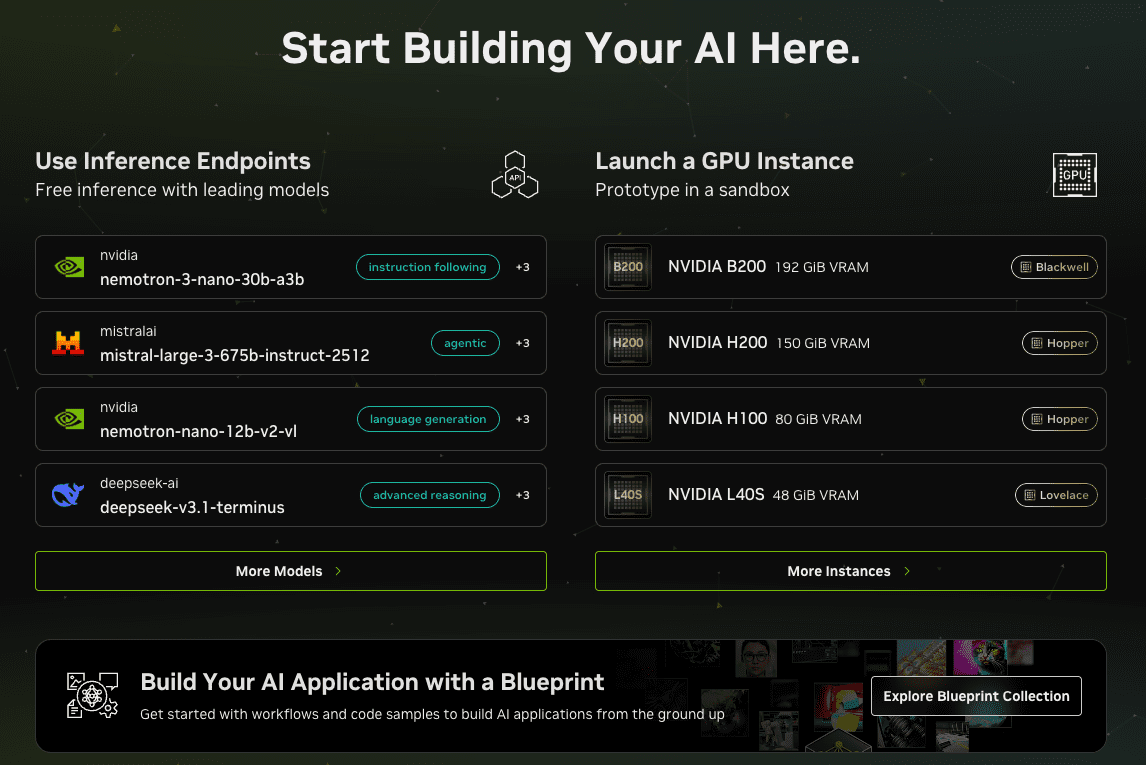

为了展示这一点,他们建立了一个 build.nvidia.com 的模型广场,把市面上最强的开源模型(Llama 3, Mistral, Gemma)以及合作伙伴的闭源模型(比如这次的 GLM 和 Minimax)都搬了上来。

对于我们开发者来说,这意味着什么?

- 开箱即用:不需要自己租 GPU,不需要折腾 Docker 和环境配置。

- 极致优化:底层基本都用了 TensorRT-LLM 进行加速,延迟(Latency)通常比原始官方 API 还要低。

- 免费额度:NVIDIA 为了推广,给每个新注册账号(或者是每个模型)都提供了相当大方的免费 credits(通常是前 1000 次调用或者一定金额的额度),对于测试和个人小项目来说绰绰有余。

深度分析:GLM-4.7 与 Minimax-m2.1

这次上新的两个主角,在国产模型圈里都是第一梯队的存在。

GLM-4.7 (智谱 AI)

虽然大家更熟悉的是 GLM-4 或者 GLM-4-9B,但这次 NVIDIA 标注的 GLM-4.7 似乎是一个针对推理平台优化的特定版本(也有可能是对应最新的 GLM-4-Plus 能力的微调版)。

在实际测试中,我发现它在 中文语境理解 和 逻辑推理 上依然保持了极高的水准。

- 指令遵循:对于复杂的 JSON 格式输出要求,GLM-4.7 的执行非常严格,很少出现格式错误。

- 长文本:虽然 API 也就是标准的上下文长度,但在处理几千字的文档摘要时,它没有出现明显的“迷糊”现象。

Minimax-m2.1 (稀宇科技)

Minimax 一直以来在 Roleplay (角色扮演) 和 拟人化 方面有着独特的优势。m2.1 版本给我的感觉是更“聪明”了。

- 语气自然:相比于 GLM 的严谨,Minimax 的回复更像是在聊天,更接地气。

- 创意写作:如果你是用来写小说大纲,或者生成一些文案创意,m2.1 的脑洞明显要大一些。

平台加持

最让我惊喜的其实不是模型本身,而是速度。在 NVIDIA 的平台上调用这两个模型,首字生成时间(TTFT)极快,Token 的生成速度就像流水一样顺滑。这明显是 TensorRT-LLM 优化后的结果。相比于有时候不稳定的官方接口,NVIDIA 的基础设施确实稳。

实践经验

接入过程非常简单,因为 NVIDIA NIM 完全兼容 OpenAI 的接口格式。

第一步:获取 API Key

- 访问并注册 build.nvidia.com,生成 API Key 需要验证手机号

- 在搜索框输入 "GLM" 或 "Minimax"。

- 点击进入模型页面,点击右上角的 "Get API Key"。

- 生成并复制你的 Key (通常以

nvapi-开头)。

第二步:代码接入

你甚至不需要安装专门的 NVIDIA SDK,直接用 openai 的 Python 包即可。

from openai import OpenAI

# 替换成你申请到的 nvapi- key

client = OpenAI(

base_url="https://integrate.api.nvidia.com/v1",

api_key="nvapi-xxxxxxxxxxxxxxxxxxxxxxxxxxxxx"

)

# 测试 GLM-4.7

completion = client.chat.completions.create(

model="thudm/glm-4.7", # 注意:这里具体的 model name 需要参考页面上的 API 代码示例,可能会有所不同

messages=[{"role":"user","content":"请用一句话解释什么是量子纠缠。"}],

temperature=0.5,

top_p=1,

max_tokens=1024,

stream=True

)

for chunk in completion:

if chunk.choices[0].delta.content is not None:

print(chunk.choices[0].delta.content, end="")

避坑指南:

- 模型名称:NVIDIA 平台上的模型 ID 有时候会比较长,比如可能叫

thudm/glm-4.7-hf之类的。一定要复制页面上API选项卡里的准确名称,不要凭感觉猜。 - 流式输出:强烈建议开启

stream=True,体验会好很多。 - 额度监控:虽然是免费试用,但也要留意 Dashboard 里的额度消耗。目前的政策是每个模型可能有独立的试用额度,用完了可能需要绑卡或者切换其他模型。

最后

这次 NVIDIA 开放 GLM-4.7 和 Minimax-m2.1 的 API,对于我们开发者来说绝对是个好消息。

一方面,它提供了一个极其稳定的备用接口。当官方 API 抽风或者我们需要在海外服务器上快速调用国产模型能力时,NVIDIA 的节点是一个绝佳的选择。另一方面,这也是一个信号,说明国产大模型的技术实力已经得到了国际顶级硬件厂商的认可,开始通过标准化的微服务形式走向全球开发者。

无论你是想用来做个翻译插件,还是给自己的 AI Agent 加上更强的中文大脑,我都建议你去试一试。毕竟,白给的高性能算力,不用白不用,对吧?

最后如果你也想在线体验这两个模型,可以注册我的 API 代理 在线体验。