共计 3021 个字符,预计需要花费 8 分钟才能阅读完成。

前段时间,为了做一个个人的即时资讯聚合项目,我需要从几个没有提供 RSS 甚至 API 的网站上抓取数据。

起初,我像往常一样写了几个简单的 Python 脚本,配合 BeautifulSoup 和 Requests,在本地跑得挺欢。但很快问题就来了:有的网站加上了反爬验证,有的网站结构三天两头变,更麻烦的是,我得自己在服务器上配定时任务,还得担心 IP 被封。维护这些"一次性"脚本的成本,逐渐超过了获取数据本身的价值。

这让我开始思考:有没有一个现成的平台,既能帮我解决代理、指纹浏览器这些底层脏活累活,又能像跑 Docker 容器一样简单地管理这些爬虫脚本?

在搜索了一圈 Headless Browser 和 RPA 方案后,我重新关注到了 Apify。虽然以前听说过,但这次深入试用后,发现它已经进化成了一个相当成熟的"网页自动化云平台"。

Apify 是什么?

简单来说,Apify 的愿景是 "Turn the web into an API"(将网页转化为 API)。

在这个 Web 2.0 甚至 Web 3.0 的时代,尽管 API 经济已经很发达,但依然有海量的信息被封闭在网页的前端展示层中。Apify 提供了一套完整的工具链和基础设施,让你能够编写、部署和监控被称为 "Actor" 的程序。这些 Actor 可以模拟人类在浏览器中的操作,访问网页、提取数据,甚至执行复杂的自动化流程。

你可以把它想象成是一个专门为爬虫和自动化任务设计的 Serverless 平台。你不需要关心服务器扩容、IP 轮询、甚至不需要关心无头浏览器(Headless Browser)的启动和销毁,只需要专注于"如何从页面上拿到我想要的数据"。

核心特性与深度体验

在使用 Apify 的这段时间里,有几个特性让我印象深刻,它们极大地提升了我的开发效率。

Actor 生态系统

Apify 的核心概念是 Actor。它本质上是一个云端的无服务器应用,通常基于 Node.js 或 Python 构建。

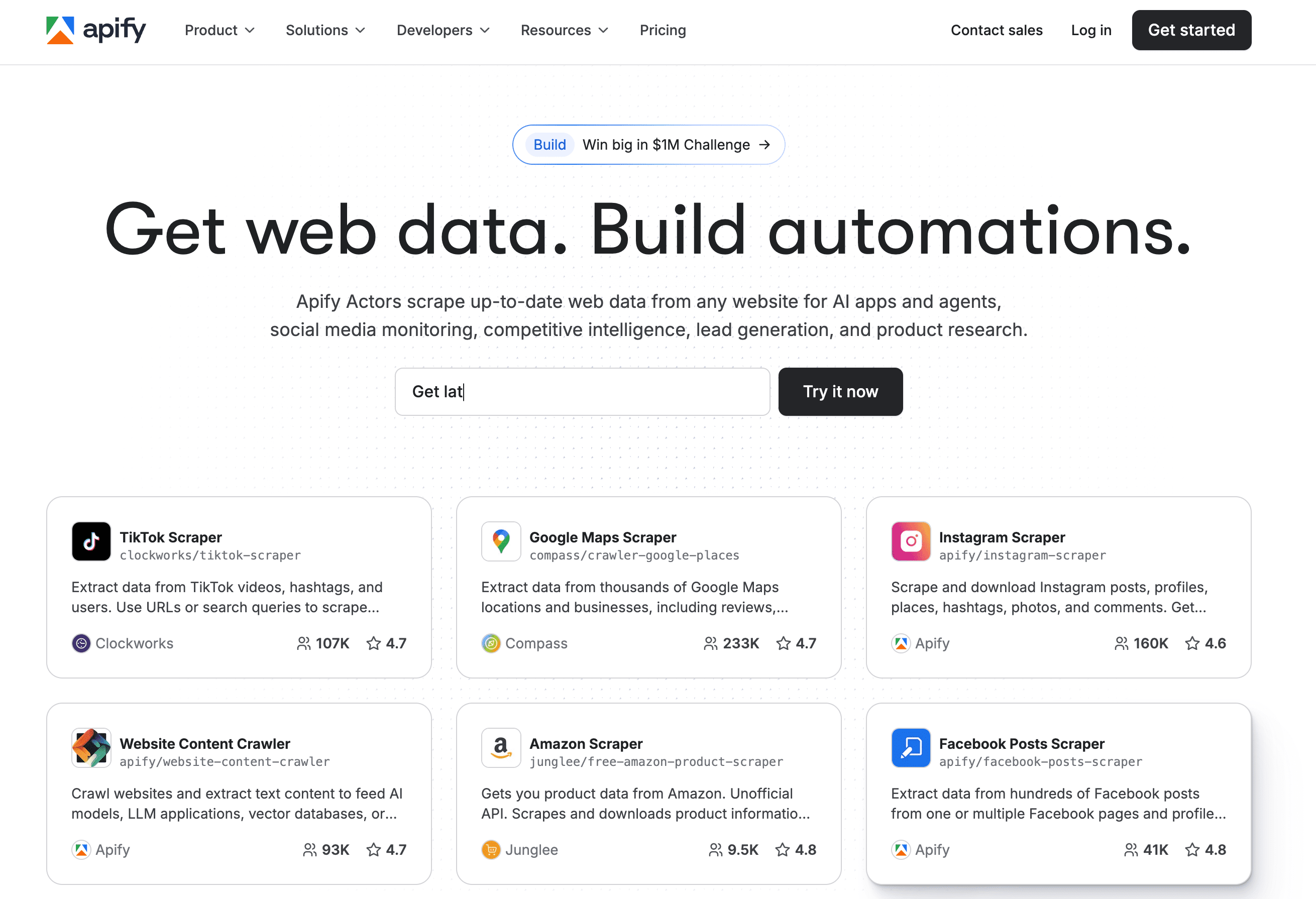

最让我惊喜的是它的 Apify Store。这里就像是爬虫界的 App Store,里面有成千上万个现成的 Actor。比如你想抓取 Instagram 的帖子、Google Maps 的商家信息、Amazon 的价格,或者 TikTok 的视频,大概率都能在商店里找到别人写好的成品。

对于不想写代码的用户,直接租用这些 Actor,输入 URL,点击运行,就能导出 Excel 或 JSON 数据,非常方便。

强大的开源库 Crawlee

作为一个喜欢写代码的人,我更看重它的开发体验。Apify 开源了一套名为 Crawlee 的 Node.js 库。

如果你写过 Puppeteer 或 Playwright,你一定经历过处理各种 await、重试逻辑、并发控制的痛苦。Crawlee 把这些都封装得非常优雅。它自动处理了:

- 智能的请求队列管理

- 自动轮询代理 IP

- 模拟浏览器指纹(防止被识别为机器人)

- 自动重试失败的请求

我之前用原生 Playwright 写的一个爬虫,迁移到 Crawlee 后,代码量减少了三分之一,而且稳定性显著提升。

解决"被封"的痛点

做过爬虫的朋友都知道,最头疼的不是解析 DOM,而是应对反爬。

Apify 平台内置了强大的代理服务(Proxy)。你可以选择数据中心代理(速度快但容易被封)或者住宅代理(Residential Proxy,模拟真实用户家庭宽带,很难被封)。配合它的指纹生成技术,基本上可以绕过绝大多数常见的反爬机制(如 Cloudflare 的一些基础防护)。这一点,对于个人开发者来说,自己搭建的成本极其高昂,而 Apify 直接作为基础设施提供了。

实践经验:监控特定商品价格

为了让你更直观地感受 Apify 的工作流,分享一个我最近的实际应用场景:监控某电商网站上特定型号显卡的价格,并在降价时通知我。

选择工具

虽然 Store 里有现成的 Amazon Scraper,但为了灵活性,我选择自己写一个简单的 Actor。我使用了 Apify CLI 工具在本地初始化项目:

apify create my-price-monitor

编写逻辑

在生成的代码框架中,我主要关注 main.js。利用 Crawlee 的 PlaywrightCrawler,逻辑非常直观:

import { Actor } from 'apify';

import { PlaywrightCrawler } from 'crawlee';

await Actor.init();

const crawler = new PlaywrightCrawler({

requestHandler: async ({ page, request, log }) => {

log.info(`Processing ${request.url}...`);

// 等待价格元素加载

await page.waitForSelector('.product-price');

// 提取价格文本

const priceText = await page.locator('.product-price').textContent();

const price = parseFloat(priceText.replace('$', ''));

log.info(`Current price: ${price}`);

// 将结果存入 Apify 默认数据集

await Actor.pushData({

url: request.url,

price,

timestamp: new Date(),

});

},

});

await crawler.run(['https://example-shop.com/product/rtx-4090']);

await Actor.exit();

部署与调度

写完代码,一条命令 apify push 就直接部署到了云端。

接着,我在 Apify 控制台的 Schedules 面板中,设置了一个 Cron 表达式,让它每小时运行一次。

集成通知

Apify 的 Integrations 非常好用。我配置了一个 Webhook,当 Actor 运行成功(Succeeded)时,触发我的一个 n8n 工作流。n8n 会检查数据中的价格字段,如果低于我设定的阈值,就通过 Telegram Bot 给我发消息。

遇到的坑与建议

虽然 Apify 很强大,但在使用中也有一些需要注意的地方:

- 成本控制:Apify 是按照计算资源(内存 x 时间)和代理流量收费的。免费层级(Free Tier)每个月有 $5 的额度,对于个人小项目通常够用。但如果你使用了高配置的住宅代理或者跑了非常耗时的无头浏览器任务,额度消耗会非常快。建议在开发阶段多利用本地环境调试(Apify CLI 支持本地运行),生产环境尽量优化代码执行效率。

- 数据格式不统一:如果你使用 Store 里的第三方 Actor,你会发现每个作者输出的 JSON 格式都不太一样。在进行数据清洗时需要多花点心思。

- 学习曲线:虽然有 Store,但要发挥它最大的威力,你还是需要掌握一定的 JavaScript/Node.js 知识,特别是对异步编程的理解。

最后

经过这段时间的折腾,我越来越觉得,Apify 不仅仅是一个工具,更像是一个连接 Web 数据与现代应用的"中间件"。对于开发者来说,它把最耗时的"基建工作"外包了出去,让我们能专注于数据价值本身。无论是用来做竞品分析、内容聚合,还是为 AI 模型提供训练语料,Apify 都是目前市面上综合体验最好的选择之一。

如果你也像我一样,经常需要从网页上"抠"点数据下来,不妨去试试看。哪怕只是用它的免费额度,跑几个定时的小脚本,也足够解决很多日常的自动化需求了。